История создания

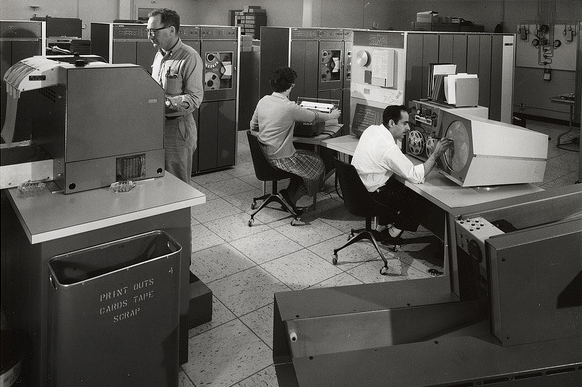

История компьютеров и масштабных вычислений началась относительно недавно. В начале 20-го века только самые смелые могли делать прогнозы относительно развития концепции автоматизированных вычислений и их применения в моделировании различных процессов. Не говоря уже о фантастической концепции глобальной информационной связи. Сложно было представить, как некое автоматическое устройство сможет заменить целый зал с плотно рассаженными за столами математиками неплохого уровня. Однако количество знаний, накопленное в самой математике и смежных дисциплинах, привели к грандиозному качественному скачку. Но истории свойственно повторяться. Она делает витки, в которых прошлое повторяется, но на новом качественном уровне. Примерно также произошло в отрасли больших вычислительных машинных залов. На заре компьютерной эры вычислители занимали целые помещения или постройки, потребляли много энергии, требовали специализированной инфраструктуры и различный обслуживающий персонал.

Всё для того, чтобы выполнить миллионы операций в секунду. Громадными шагами двигая вперёд те отрасли, для которых производили вычисления. Сложные мейнфреймы с терминалами доступа, разнесёнными в пространстве одного учреждения. Множество периферийных пользовательских мест простых и дешёвых были связаны с одним дорогим центральным компьютером или целым машинным залом. Машинное время стоило много и было доступно не всем желающим в произвольный момент времени. Расписывалась очерёдность, где чётко было выделено время, когда группа учёных могла просчитать свой проект, предварительно поработав над кодом своих программ на бумаге. Ничего отдалённо не напоминает?

ЦОД это

ЦОД – Центр Обработки Данных (датацентр). Это вычислительный центр с высокой производительностью, безопасностью и доступностью. По сути, это тот же центральный мейнфрейм, предоставляющий вычислительные ресурсы и различные сервисы своим удалённым пользователям. С той разницей, что вычислительная мощность выросла до величин с приставками из космологии: Гига-, Тера-, Пета- и даже Экса-. Да и сервисы стали настолько разнообразными, что стали полезны не только лучшим профильным специалистам, но и всем желающим, любой компании с любым количеством сотрудников и любыми бизнес-задачами. Конечно, ЦОД может быть и небольшим. Существуют решения для установки в одном помещении или аппаратной стойке. В виде плотно скомпонованного блока или шкафа. Такие решения позиционируются как персональные, для небольших компаний. Однако, чаще всего, выгоднее брать в аренду сервера и сервисы в большом датацентре. Это решает множество вопросов и облегчает жизнь, конвертируя машинное время в полезный и надёжный инструмент для ведения бизнеса.

Современные ЦОД'ы обладают следующими характеристикам:

Класс отказоустойчивости

Необходимость классификации по характеристикам отказоустойчивости возникла как результат проектирования ЦОДов под различные задачи, для самых разных отраслей и критичности сценариев использования. Поэтому надёжность хостинга и сервисов стоит отдельно, на первом месте. Все современные ЦОД попадают под действие стандарта TIA 942, принятого за эталонный в США и других странах. Он включает в себя четыре уровня надёжности:

Tier I (N)

Ненадёжная инженерная система без резервирования. Только оборудование для обеспечения главных задач. Не предусмотрено резервирование по питанию. Сбой оборудования или остановка на обслуживание приводит к полной остановке всей системы. Допустимо любое время простоя за год.

Tier II (N+1)

Включено резервирование по энергоснабжению, минимальное резервирование основных устройств. Используются фальшполы. Однако проведение обслуживания также сопровождается простоем в работе. Допустимо время простоя за год порядка 20 часов. Надёжность оценивается в 99,7 %.

Tier III (N+1)

Практически всё оборудование задублировано. Имеется несколько каналов питания, хотя, как правило, активен один. Такая схема позволяет не останавливать работу датацентра при обслуживании и замене вышедших из строя компонентов. Допустимо время простоя за год около 2 часов. Оценочная надёжность – 99,9 %.

Tier IV (2(N+1))

Двукратное резервирование всех систем. Это значит, что полное резервирование основной системы также имеет свое резервирование. Такой подход позволяет проводить любые работы по обслуживанию, замене и ремонту без нарушения работоспособности всего комплекса. Самая высокая надёжность – 99,99 %.

Ёмкость ЦОД

Данная характеристика не менее важна, поскольку характеризует ЦОД по размеру и мощности. В последнее время многие компании стараются построить свой собственный датацентр. Это предпочтительно с позиции независимости и безопасности. Часто используют готовые площади и помещения, оставшиеся от заводов, складов или прочих пригодных построек. Как наземных, так и подземных. Этот путь позволяет экономить как на строительстве, землеотводной документации, так и на уже существующей инфраструктуре коммуникаций. Конечно, любой проект современного ЦОД потребует глубокой проработки и перепроектирования. Но это гораздо дешевле строительства «с нуля». Будущая емкость и масштабируемость датацентра закладывается ещё на этапе проектирования. Машинные залы рассчитываются на определённое количество стоек под сетевое и вычислительное оборудование.

В фальш-потолках размещаются коммутационные кабели, несущие фермы, системы оповещения и пожаротушения. В двойных полах – коммуникации систем охлаждения и силовые кабели питания. Полы обычно делаются съёмными, из негорючих материалов или же из металла. Большие ЦОД вмещают сотни стоек и шкафов. Ограничения наложены площадью залов, энергопотреблением и мощностью охлаждения.

"

Мы обеспечиваем централизованную поставку оборудования и материалов на объект, гарантируя 100% контроль качества продукции. Это позволяет нам создавать надежные широкополосные сети и предоставлять долгосрочную гарантию.

В работе используются только высококачественные компоненты, материалы, инструмент. Все работы выполняются на высоком профессиональном уровне с соблюдением требований к технологиям монтажа производителей "

Мощность электроснабжения

Датацентр потребляет большую мощность. На этапе проектирования этому вопросу уделяется пристальное внимание. Должны быть соответствующие возможности подвода необходимого числа силовых кабелей. Возможно, потребуется собственная подстанция. В зависимости от класса отказоустойчивости используются определённые типы источников бесперебойного питания. Также хорошим вариантом будут дизель-генераторы. Они могут обеспечить питание ЦОД на сколь угодно долгий период времени, в отличие от ИБП с батареями. Часто данные системы используются параллельно, поскольку время аварийного срабатывания ИБП – доли секунды, а генератору для запуска может потребоваться до минуты. Генератор находится в специальном помещении с вентиляцией и шумоизоляцией. При верном расчёте данные устройства обеспечивают резервирование по питанию и напрямую влияют на надёжность ЦОД. Крупный датацентр потребляет сотни киловатт энергии. Одна стойка может потреблять до 10 кВт и выделяет тепло, которое нужно отводить.

Мощность охлаждения

Система охлаждения также является весьма важной. При работе компонентов ЦОД выделяется большое количество тепла, которое необходимо быстро отводить. Тут могут использоваться промышленные кондиционеры для воздушного охлаждения, жидкостное охлаждение и иные типы отбора лишнего тепла. Самые энергоэффективные проекты используют выделенное тепло для отопления помещений персонала или же близлежащих построек. Для этого используются различные воздуховоды или трубопроводы. Встречаются и экзотические варианты, но тем не менее существующие – охлаждение грунтовыми водами и холодными слоями грунта. Мощность, резервирование и запас холода на определённое время – основные моменты в системе охлаждения для ЦОД. Все системы требуют внимания при проектировании, последующем строительстве и эксплуатации. Порядок мощности охлаждения – до 30 кВт на одну стойку.

Сетевая инфраструктура и транковые линии

Огромные объёмы данных требуют широких каналов передачи. Тут нужны технологии соединения как с операторами, предоставляющими широкополосный доступ, так и транки с другими датацентрами. Внутри ЦОД стойки соединяются между собой и серверами по средствам оптических каналов до 100 Гбит/с или же медными линиями со сходной пропускной способностью. Оптические линии от нескольких операторов обеспечат резервирование на случай проблем у одного из них. Все кабели прокладывают на специальных фермах, в изолирующих и защитных рукавах. Подходят к шкафам с кросс-панелями, где разводятся и подключаются к конечному устройству специальными отводами (пигтейлами) с соответствующими коннекторами. Качество и надёжность линий связи весьма важны. Поэтому укладке, сварке и разводке таких линий уделяется самое пристальное внимание. Тут нужен подрядчик с большим опытом и хорошей репутацией. Общая длина каналов передачи может составлять сотни километров.

Диапазон температур и система пожаротушения

Всё оборудование датацентра рассчитано на функционирование в определённом температурном диапазоне. Притом, что внешняя температура среды может колебаться от -40˚ до +40˚ С, в пределах помещений она должна оставаться постоянной. В машинных залах за это отвечает система охлаждения и подогрева. В помещениях персонала также необходимы климатические установки. Предельно допустимая концентрация пыли – также регламентированный параметр. С пылью борятся увлажнители и фильтро-вентиляционные установки. Сколь надёжным не было бы оборудование, не исключена вероятность возникновения нештатной ситуации. Система пожаротушения призвана обезопасить персонал и минимизировать убытки. Для таких систем, как правило, отводятся небольшие комнаты. В них размешаются промышленные порошковые огнетушители, соединенные в сборки и система автоматики.

Системы жизнеобеспечения

Для обслуживания ЦОД нужен персонал. Инженеры-наладчики, операторы и технический персонал. Охрана периметра и территории. Складские работники. Это далеко не полный перечень занятых в ЦОД людей. Также может быть предусмотрена возможность присутствия сотрудников заказчика, если мощности датацентра сдаются в аренду. Обязательно присутствует склад для хранения резервных компонентов. И поскольку присутствуют люди, им необходимы специальные помещения для труда, отдыха и приёма пищи. Усидчивость и производительность персонала напрямую зависит от условий труда и отдыха. Поэтому данному вопросу необходимо уделять должное внимание.

Таким образом, строительство собственного ЦОД требует тщательной проработки многих аспектов и вопросов. Результат будет зависеть от многих сотен специалистов – от проектировщиков, рисующих будущий датацентр в 3D, поставщиков оборудования, инженеров-наладчиков различных систем до строителей. Множество подрядчиков, которых необходимо контролировать и координировать. Именно поэтому предпочтения нужно отдать исполнителям с опытом ведения подобных проектов. Это на ранних стадиях избавит от многих проблем, а также позволит избежать нестыковок в работе и задержек одних бригад другими. Именно поэтому, лучше всего, если генпроектировщик и генподрядчик – одна и та же организация. Чёткое следование документации и ГОСТам – фундамент на долгие годы, сильно облегчающий самый сложный и ответственный этап – строительство и пуск.